AIで人間の脳から音楽的な本能が生まれる原理解明 韓国

韓国科学技術院(KAIST)は1月23日、同院の物理学科(Department of Physics)のジョン・ハウン(Jung Hawoong)教授率いる研究チームが、人工ニューラルネットワークモデルを用いて、特に学習しなくても人間の脳から音楽的な本能が生まれる原理を突き止めたと発表した。この研究成果は、Nature Communicationsに掲載された。

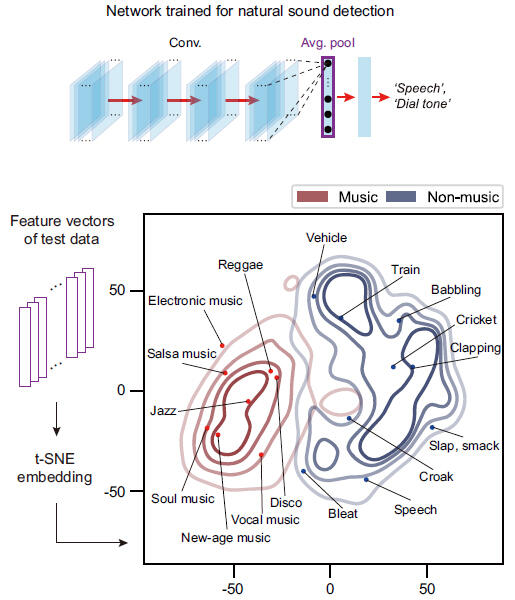

研究チームは、グーグル(Google)が提供する大規模な音データのコレクションであるAudioSetを利用し、人工ニューラルネットワークにさまざまな音を学習させた。その結果、ネットワークモデル内の特定のニューロン(神経細胞)が音楽に選択的に反応することを発見した。つまり、動物や自然、機械などの音には最小限の反応しか示さないものの、楽器と歌両方の音楽には高い反応を示すニューロンが自然に生成されることが観察された。

脳の音楽性と人工ニューラルネットワークのイラスト

(created with DALL·E3 AI based on the paper content)

人工神経回路網モデルのニューロンは、実際の脳の聴覚皮質に含まれるニューロンと類似する反応行動を示した。例えば、音楽を短く区切って並べ替えたところ、人工ニューロンはあまり反応しなかった。このことは、自然発生的に生成された音楽選択性ニューロンが、音楽の時間構造を符号化していることを示している。この性質は特定の音楽ジャンルに限定されず、クラシック、ポップス、ロック、ジャズ、エレクトロニックなどの25種類のジャンルで現れた。

さらに、音楽選択性ニューロンの活動を抑制すると、他の自然音に対する認知精度が大きく損なわれることがわかった。つまり、音楽情報を処理する神経機能は他の音の処理にも役立っており、「音楽的能力」は自然界の音をよりよく処理するための進化的適応の結果として形成された本能とも考えられる。

サイバー空間において非音楽的な自然音を認識することを学習した人工ニューラルネットワークは、音楽と非音楽を区別する

(出典:いずれもKAIST)

ジョン教授は、「我々の研究結果は、進化的圧力が、さまざまな文化における音楽情報処理の普遍的基盤の形成に寄与したことを示唆している」と述べ、開発した人工的なモデルが「AIによる音楽生成、音楽療法、音が得認知の研究などのさまざまな用途のための原型」になるとの期待を示した。

サイエンスポータルアジアパシフィック編集部